기기 내에서, 오직 나를 위한: Khadas Mind를 이용하여 개인 AI 구축하기

- 투바 주식회사

- 2025년 4월 23일

- 6분 분량

최종 수정일: 2025년 6월 2일

점점 더 많은 사람들이 대규모 AI 모델을 로컬에서 실행하고 싶어 하며, 개인 기기에서 AI의 강력한 기능을 직접 경험하고 싶어 합니다. 하지만 막상 실행에 옮기면 현실이 닥쳐옵니다. 네트워크 문제로 인한 잦은 연결 시간 초과, 특히 다소 복잡한 질문을 할 때 모델이 종종 관련성이 없거나 무의미한 답변을 내놓는 경우입니다. 결국 AI의 답변을 수정하는 것은 직접 작성하는 것보다 훨씬 더 힘든 일입니다!

그렇다면, 당신에게 진정으로 적합한 로컬 AI 시스템이 있을까요?

가장 똑똑한 AI는 사용자가 제어하는 AI입니다.

AI가 정말로 개인 비서가 된다면 어떠한 기능을 가지게 될까요?

차이점을 느끼실 수 있나요?

대형 AI 모델 + 사용자의 데이터 = 오직 나를 위한 개인 AI 비서!

로컬 배포에는 미니 PC가 최선의 선택이며, Khadas Mind가 이 분야를 선도하고 있습니다.

개인용 컴퓨터에서 AI를 비공개로 실행하려는 많은 사람들이 클라우드나 집에 있는 데스크톱 및 노트북에 대규모 모델을 배포하는 방법을 모색하고 있습니다. 하지만 사용자들과의 인터뷰를 통해 미니 모듈러 PC가 실제로 대규모 모델을 로컬에서 실행하는 가장 효과적인 방법일 수 있다는 것을 알게 되었습니다. 그 이유는 다음과 같습니다.

에너지 효율, 고성능, 상시 작동

수백 와트의 전력을 소모하는 데스크톱이나 서버와 달리, 미니 모듈러 PC는 일반적으로 20W에서 50W의 전력으로 작동하여 전기 요금을 절감합니다. 24시간 연중무휴 안정적인 작동으로 개인 AI 비서는 필요할 때 언제든 사용할 수 있습니다.

소형 및 공간 절약형

작업 공간을 어지럽히는 부피가 큰 타워형 PC나 노트북과 달리, Khadas Mind와 같은 미니 모듈러 PC는 어떤 환경에도 깔끔하게 설치됩니다. 구석에 조용히 두거나 서랍에 넣어도 방해가 되지 않습니다. 또한 매우 조용하고 발열이 적어 소음 제어 측면에서 일반 데스크톱보다, 열 효율 측면에서 노트북보다 뛰어나 장기간 중단 없이 사용하기에 적합합니다.

로컬 AI, 클라우드가 없다면? 문제없습니다.

클라우드 기반 AI는 편리해 보일 수 있지만, 심각한 제약이 있어 일상적인 사용에는 적합하지 않습니다.

구독료와 API 호출 요금이 빠르게 증가합니다. 개발자나 고급 사용자의 경우, 클라우드를 통해 대규모 모델과 상호 작용하면 상당한 비용이 발생할 수 있습니다. 특히 API가 사용량 기반 요금제로 제한되고 점점 더 제한되는 경우 더욱 그렇습니다.

입력하는 모든 단어는 클라우드로 전송됩니다. 개인적인 채팅, 중요한 업무 문서, 독점 코드 등 어떤 내용이든 기기에서 나가는 순간 데이터가 노출되어 유출, 침해 또는 무단 사용에 취약해집니다.

인터넷이 없다면? AI도 없습니다. 연결 상태가 약하거나 불안정하더라도 클라우드 AI가 느려지거나 전혀 응답하지 않을 수 있습니다. 어시스턴트가 "매우 똑똑"하다가 "매우 느림"으로 변하거나, 더 심한 경우 아예 응답하지 않을 수도 있습니다.

미니 PC와 로컬 증류 모델의 조합은 성능, 개인 정보 보호, 안정성의 완벽한 균형을 제공합니다. 데이터 보안과 워크플로우 안정성을 유지하면서도 충분한 컴퓨팅 성능을 제공하므로, AI를 효율적이고 저렴하게 구축하려는 개인 사용자와 소규모 팀에게 이상적인 솔루션입니다.

이제 Khadas Mind를 사용할 수 있는 또 다른 강력한 방법을 개발하였습니다.

바로 집이나 사무실에서 바로 사용할 수 있는 작고 항상 켜진 AI 허브로 바꾸는 것입니다.

어디에나 설치 가능 시중에서 가장 작은 고성능 PC 중 하나인 Khadas Mind는 책상, 선반, 심지어 서랍 안에도 손쉽게 설치할 수 있습니다. 초슬림 경량 디자인으로 어디든 간편하게 이동할 수 있습니다. | 즉시 확장 가능 더 강력한 성능이 필요하신가요? Mind Link 인터페이스를 통해 Mind Graphics를 연결하기만 하면 몇 초 만에 AI 성능을 극대화할 수 있습니다. | 항상 준비 완료 내장 배터리 덕분에 Khadas Mind는 짧은 이동이나 정전 중에도 전원을 유지합니다. AI 비서는 대기 상태를 유지하며, 종료나 재부팅 없이 매끄럽게 작동합니다. |

대규모 모델과 RAGFlow를 로컬에 배포하여 나만의 개인 AI 비서를 만들어 보세요.

오늘은 Khadas Mind를 활용하여 나만의 AI 비서를 만드는 방법을 안내해 드리겠습니다. RAGFlow와 함께 사용하면 AI는 단순히 질문에 답하는 데 그치지 않고 학습 자료, 업무 문서, 개인 메모까지 이해하여 사용자를 가장 잘 아는 진정한 지능형 동반자로 발전합니다.

이 데모에서는 Khadas Mind 2와 16GB Mind Graphics eGPU 모듈을 사용합니다. 이 강력한 구성은 대부분의 로컬 배포 요구 사항을 충족하는 충분한 성능을 제공하여 개인 사용자와 소규모 팀 모두에게 이상적입니다.

하드웨어 환경:

Khadas Mind 2 Ai Maker Kit(Intel® Core™ Ultra 7 프로세서 258V, 32GB RAM, 1TB SSD 탑재).

16GB Mind Graphics(데스크톱급 4060 Ti 그래픽 카드, 16GB VRAM 탑재).

전력 소비량: 대기 시 30W, 최대 부하 시 235W.

총 용량: 2.5L

설치 과정

필수 구성 요소

운영 체제: Windows 11 Home(영어)

Windows 11에서: 제어판 -> 프로그램 -> Windows 기능 켜기/끄기에서 다음 항목을 활성화하세요.

– 가상 머신 플랫폼

– Windows 하이퍼바이저 플랫폼

– Linux용 Windows 하위 시스템

위 설정을 변경한 후 컴퓨터를 다시 시작하세요.

저희는 두 가지 설치 방법을 제공합니다:

1. 빠른 배포

Ollama, Docker, RAGFlow를 포함하는 소프트웨어 패키지를 개발했으며, Deepseek 14b 모델이 기본적으로 포함되어 있습니다. 설치가 완료되면 최소한의 구성만으로 사용할 수 있습니다.

설치 패키지 다운로드: https://dl.khadas.com/development/llm/ragflow.zip

Docker 및 Ollama 설치:

Installers 폴더에 Docker 애플리케이션을 설치하고 설치가 완료되면 기기를 다시 시작하세요.

Installers 폴더에 Ollama 애플리케이션을 설치하고 설치가 완료되면 기기를 다시 시작하세요.

스크립트 실행: 위 두 항목을 설치한 후 !_install.bat 스크립트를 실행하세요. (Khadas Mind가 인터넷에 연결되어 있는지 확인하세요.)

설치가 완료되면 아래 2.6에 따라 RAGFlow를 실행하고 Ollama 모델을 추가한 후 구성을 계속하세요.

2. 사용자 지정 배포

모델 버전 수정 등 필요에 따라 조정할 수 있습니다.

2.1 Ollama 설치 및 실행

Ollama 다운로드 링크: https://ollama.com/download/OllamaSetup.exe

다운로드 후 Ollama를 설치하고 시스템을 다시 시작합니다.

Win + R 키를 누르고 대화 상자에 "cmd"를 입력한 후 Enter 키를 누르고 다음 명령을 입력하여 채팅 모델을 다운로드합니다.

ollama pull deepseek-r1:14b

다음 명령을 입력하여 임베드 모델을 다운로드합니다.

ollama pull nomic-embed-text

환경 변수를 설정합니다. 설정 -> 시스템 -> 정보 -> 고급 시스템 설정 -> 환경 변수...로 이동합니다. 시스템 변수 창에서 새로 만들기...를 클릭합니다.

변수 이름으로 "OLLAMA_HOST"를 입력합니다.

변수 값으로 "0.0.0.0:11434"를 입력합니다.

변경 사항을 적용하려면 시스템을 다시 시작해야 합니다.

2.2 Docker 설치

Docker 다운로드 링크:

다운로드가 완료되면 설치 프로그램을 실행하고 안내에 따라 Docker를 설치합니다.

2.3 git 설치

Win + R 키를 누르고 대화 상자에 "cmd"를 입력하고 Enter 키를 누른 후 다음 명령을 입력합니다.

winget install --id Git.Git -e --source winget

2.4 wsl 설치

Win + R 키를 누르고 대화 상자에 "cmd"를 입력하고 Enter 키를 누른 후 다음 명령을 입력합니다.

wsl –update

업데이트 프로세스가 완료될 때까지 기다렸다가 다음 단계로 진행합니다.

2.5 RAGFlow 저장소 복제

ragflow라는 이름의 폴더를 만들고 마우스 오른쪽 버튼을 클릭한 후 '터미널에서 열기'를 선택하고 다음 명령을 입력하세요.

cd ragflow/docker

터미널을 닫지 마세요. Docker Desktop을 실행한 후 이 튜토리얼을 계속 진행하세요.

다음 오류 메시지가 나타나면 터미널에서 wsl --update를 다시 실행하세요.

Docker Desktop을 시작한 후 건너뛰기를 클릭하면 다음 화면이 나타나 모든 것이 정상임을 나타냅니다.

터미널로 돌아와 다음 명령을 계속 실행하세요.

docker compose -f docker-compose.yml up –d

일반적인 상황에서 Docker는 다음과 같이 필요한 이미지 파일을 가져옵니다.

시스템이 필요한 파일을 다운로드할 때까지 기다리세요. 다운로드가 완료되면 아래와 같이 표시됩니다.

RAGFlow는 기본적으로 켜져 있을 때 실행됩니다.

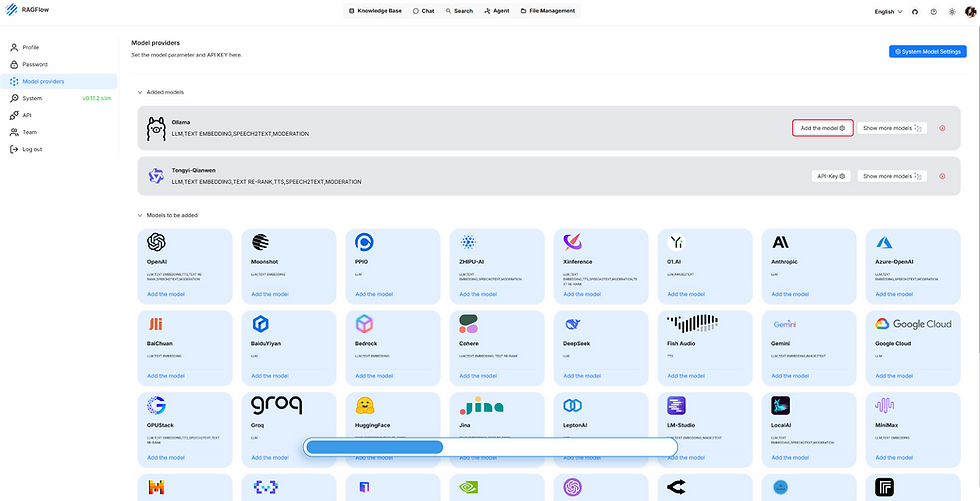

2.6 RAGFlow 실행 및 Ollama 모델 추가

컴퓨터를 재시작하고 시스템에 진입한 후 Docker Desktop을 실행합니다.

서버 IP 확인: Win + R 키를 누르고 대화 상자에 "cmd"를 입력한 후 Enter 키를 누르고 "ipconfig"를 입력한 후 IPv4 주소(예: 192.168.1.45)를 확인합니다.

브라우저를 통해 RAGFlow에 접속: 로컬 브라우저에 127.0.0.1을 입력합니다. 동일 네트워크의 컴퓨터는 192.168.1.45를 통해 접속할 수 있습니다.

Ollama를 클릭하고 먼저 채팅 모델을 추가하세요. LLM 추가 -> 모델 유형에서 채팅을 선택하세요.

모델 이름은 deepseek--r1:14b입니다.

기본 URL은 위에 표시된 것처럼 http://Ipv4 주소:11434입니다.

예: http://192.168.1.45:11434. 최대 토큰 수에는 32768을 입력하세요.

그런 다음 임베딩 모델을 추가합니다. LLM 추가 -> 모델 유형에서 임베딩을 선택합니다.

모델 이름은 nomic-embed-text:latest입니다.

기본 URL과 최대 토큰 수는 위와 같습니다.

마지막으로, 시스템 모델 설정에서 채팅 모델과 임베딩 모델을 추가합니다.

지금까지 로컬 대규모 언어 모델과 RAGFlow를 모두 구축했습니다. 여러분의 AI 비서에 "영혼"이나 "개성"을 불어넣을 차례입니다.

AI의 두뇌 구축: 진정한 개인화를 위한 맞춤형 로컬 데이터

다음으로, 배포된 대규모 언어 모델을 사용하여 나만의 맞춤형 AI 비서를 구축해 보세요.

Knowledge base 설정하기

IPV4 주소를 통해 RAGFlow 페이지를 엽니다(Docker Desktop이 이미 실행 중인지 확인하세요).

Knowledge Base > Create knowledge base > 이름 입력으로 이동합니다.

Knowledge Base > Configuration에서 임베딩 모델에 'nomic-embed-text:latest'를, Chunk method에 'General'을 선택합니다. 처음 설정하는 경우, 더 나은 사용자 경험을 위해 'General'을 선택한 후 설정을 저장하는 것이 좋습니다.

새로운 Knowledge Base 파일 생성하기

Knowledge Base를 클릭하고 이전 단계에서 만든 knowledge base를 선택하세요.

Add file를 클릭하고 로컬 파일에서 업로드할 파일을 선택하세요.

업로드가 완료되면 ▶️ 버튼을 클릭하여 파일 분석을 시작하세요. 분석이 완료될 때까지 잠시 기다린 후 사용하세요.

사용하는 방법

Chat > Create an Assistant를 클릭하고 Assistant Setting 페이지에서 사용자 지정 이름을 입력한 다음 knowledge base에서 방금 만든 사용자 지정 Knowledge base 이름을 선택합니다.

Model Setting 페이지에서 deepseek-r1:14b 모델을 선택하고 확인을 클릭합니다.

'Chat'을 클릭하여 새로운 대화를 시작하고 채팅을 통해 새로 태어난 당신만의 AI 비서를 이용해보세요.

위에서 보시는 바와 같이, 개인 맞춤형 AI 비서 구축이 완료되었습니다.

Knowledge base에 개인 문서를 추가로 업로드하여 나만의 AI 비서를 더욱 효과적으로 구축할 수 있습니다.

마무리

AI는 하드웨어 생태계에 깊이 통합되고 있으며, Khadas는 다양한 환경에서 실제 사용자 요구를 충족하도록 설계된 모듈식 멀티 시나리오 스마트 기기의 혁신 모델을 재정의하고 있습니다. 사용자 인사이트, 시나리오 기반 개발, 그리고 과감하고 반복적인 혁신을 기반으로 하는 폐쇄 루프 시스템을 구축하고 있습니다. Khadas는 고성능, 고집적도, 그리고 강력한 확장성을 제공하는 데 계속해서 집중하고 있습니다. 여러분의 의견을 기다립니다. 모든 아이디어와 제안은 지능형 크로스 시나리오 컴퓨팅의 미래를 함께 만들어가는 과정에서 더욱 스마트하고 적응력이 뛰어난 하드웨어의 진화를 촉진합니다.

감사합니다,

Khadas Team

주식회사 투바 옮김

댓글